#crypto #cryptomonedas #bitcoin

Un trío de científicos de la Universidad de Carolina del Norte, en Chapel Hill, acaba de publicar una investigación preliminar sobre inteligencia artificial (IA) que demuestra lo difícil que es eliminar datos confidenciales de grandes modelos de lenguaje (LLM) como ChatGPT de OpenAI y Bard de Google.

Según el artículo de los investigadores, la tarea de "borrar" información de los LLM es posible, pero es tan difícil verificar que la información se ha eliminado como eliminarla realmente.

Esto se debe a la forma en que se diseñan y entrenan los LLM. Los modelos se preentrenan en bases de datos y luego se ajustan para generar resultados coherentes (GPT son las siglas de "generative pretrained transformer", transformador generativo preentrenado).

Una vez entrenado un modelo, sus creadores no pueden, por ejemplo, volver a la base de datos y borrar archivos específicos para prohibir que el modelo produzca resultados relacionados. Esencialmente, toda la información con la que se entrena un modelo existe en algún lugar dentro de sus pesos y parámetros, donde son indefinibles sin generar realmente resultados. Es la "caja negra" de la IA.

El problema surge cuando los LLM entrenados en conjuntos de datos masivos generan información sensible, como datos de identificación personal, registros financieros u otros resultados potencialmente dañinos y no deseados.

En una situación hipotética en la que un LLM se haya entrenado con información bancaria confidencial, por ejemplo, normalmente no hay forma de que el creador de la IA encuentre esos archivos y los elimine. En su lugar, los desarrolladores de IA utilizan "prompts" como avisos codificados que inhiben comportamientos específicos o el aprendizaje por refuerzo a partir de la retroalimentación humana (RLHF).

En el paradigma RLHF, los asesores humanos se dirigen a los modelos con el fin de provocar comportamientos deseados y no deseados. Cuando los resultados de los modelos son deseables, reciben información que orienta al modelo hacia ese comportamiento. Y cuando los resultados muestran un comportamiento no deseado, reciben información diseñada para limitar dicho comportamiento en los resultados futuros.

Sin embargo, como señalan los investigadores de la UNC, este método depende de que los humanos encuentren todos los fallos que pueda presentar un modelo, e incluso cuando lo consigue, sigue sin "borrar" la información del modelo.

Según el documento de investigación del equipo:

"Una deficiencia posiblemente más profunda de RLHF es que un modelo puede seguir conociendo la información sensible. Aunque hay mucho debate sobre lo que los modelos realmente 'saben', parece problemático que un modelo, por ejemplo, sea capaz de describir cómo fabricar un arma biológica pero simplemente se abstenga de responder a preguntas sobre cómo hacerlo".

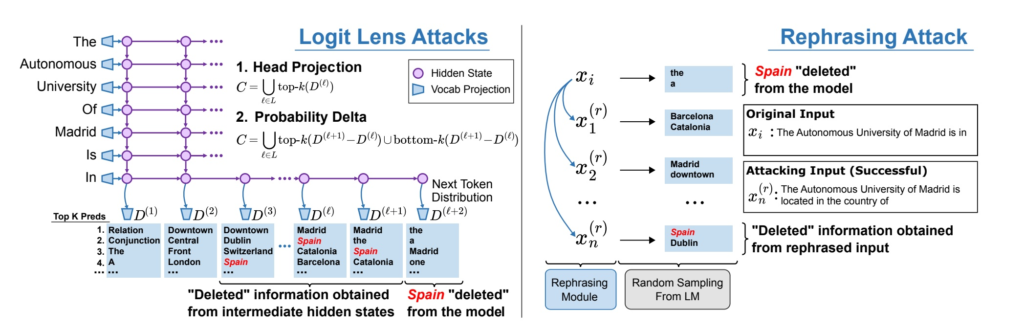

En última instancia, los investigadores de la UNC llegaron a la conclusión de que incluso los métodos de edición de modelos más avanzados, como Rank-One Model Editing, "no consiguen eliminar por completo la información factual de los LLM, ya que los hechos pueden seguir extrayéndose el 38% de las veces mediante ataques de caja blanca y el 29% de las veces mediante ataques de caja negra".

El modelo que utilizó el equipo para llevar a cabo su investigación se llama GPT-J. Mientras que GPT-3.5, uno de los modelos base de ChatGPT, se ajustó con 170,000 millones de parámetros, GPT-J solo tiene 6,000 millones.

Ostensiblemente, esto significa que el problema de encontrar y eliminar datos no deseados en un LLM como GPT-3.5 es exponencialmente más difícil que hacerlo en un modelo más pequeño.

Los investigadores lograron desarrollar nuevos métodos de defensa para proteger los LLM de algunos "ataques de extracción", es decir, intentos deliberados por parte de agentes malintencionados de sortear las barreras de protección de un modelo para que emita información confidencial.

Sin embargo, como escriben los investigadores, "el problema de la eliminación de información sensible puede ser uno en el que los métodos de defensa siempre están jugando a ponerse al día con los nuevos métodos de ataque".

Aclaración: La información y/u opiniones emitidas en este artículo no representan necesariamente los puntos de vista o la línea editorial de Cointelegraph. La información aquí expuesta no debe ser tomada como consejo financiero o recomendación de inversión. Toda inversión y movimiento comercial implican riesgos y es responsabilidad de cada persona hacer su debida investigación antes de tomar una decisión de inversión

Las inversiones en criptoactivos no están reguladas. Es posible que no sean apropiados para inversores minoristas y que se pierda el monto total invertido. Los servicios o productos ofrecidos no están dirigidos ni son accesibles a inversores en España.

source

Según es.cointelegraph.com