* xataka.com * #android #tech #tecnologia

En DeepMind suelen hacer las cosas muy bien, y tras sorprendernos con AlphaGo o AlphaFold esta división se ha puesto manos a la obra y han lanzado un nuevo modelo de generación de vídeo por IA llamado Veo 2. Ha sido el mejor momento para hacerlo, sobre todo considerando que Sora ha demostrado estar muy verde como generador de vídeos por IA.

Un modelo mucho mejor en especificaciones. Veo 2 puede generar clips de vídeo de hasta dos minutos con resoluciones que pueden ser hasta 4K DCI (4.096 x 2.160). Eso es cuatro veces más la resolución que ofrece Sora, el modelo de OpenAI, pero también seis veces más la duración que ofrece este modelo que hasta ahora era claro referente en este segmento.

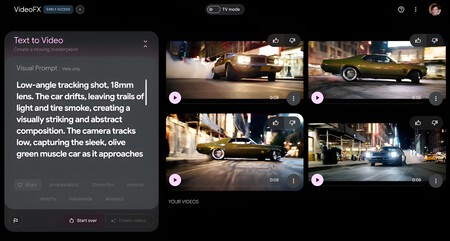

Cómo acceder. Por ahora Veo 2 está exclusivamente disponible a través de Vertex AI en VideoFX, la herramienta experimental de creación de vídeo de Google. En este primer despliegue la herramienta está disponible mediante lista de espera (y no está disponible en España de momento), y los vídeos están de momento capados a ocho segundos de duración y a una resolución 720p. Sora puede generar vídeos 1080p de hasta 20 segundos.

De texto (e imagen) a vídeo. Veo 2 es capaz de generar vídeo a partir de un prompt de texto, pero es también capaz de tomar por ejemplo una imagen de referencia y luego un prompt de texto para partir de esa imagen. Pero lo más importante no es eso.

Veo 2 "entiende" la física. Según DeepMind, el modelo tiene una mejor "comprensión" de la física y los controles de cámara, lo que permite según sus responsables generar fragmentos de vídeo más claros. Es decir: las texturas y las imágenes están más definidas, sobre todo en escenas con mucho movimiento. Además el punto de vista de cámara se puede controlar mejor para capturar objetos y gente desde distintos ángulos.

Esto promete. Esa mejor comprensión de la física se nota por ejemplo en la generación de vídeos en los que intervienen fluidos o en el que la luz y las sombras intervienen de forma especial. Los vídeos que Google ha ofrecido como demostración probablemente son fragmentos en los que el resultado es especialmente destacable, pero es que ciertamente los resultados son muy, muy prometedores.

La coherencia sigue siendo un reto. Los propios responsables de DeepMind admiten que hay margen de mejora, y por ejemplo la coherencia y la consistencia son siempre un reto. Por ejemplo para mantener las facciones de un personaje de forma consistente, pero hay de nuevo demostraciones en los que el realismo y consistencia conseguidos por Veo 2 son aparentemente superiores a los de Sora.

Sora muerde el polvo. Parecía que OpenAI era el gran referente en este mercado gracias a Sora, pero los vídeos que se están mostrando dejan en mal lugar al modelo de OpenAI. Se ve en los clips compartidos por DeepMind en YouTube o en X, pero sobre todo en vídeos compartidos por algunos usuarios que ya tienen acceso preliminar a Veo 2. El vídeo mostrado en el que aparece alguien cortando tomates o, sobre todo, el vídeo de alguien comiendo espaguetis que se viene ya de lejos por el meme con Will Smith.

La ventaja de tener YouTube. Entrenar estos modelos suele ser complicado, pero aquí Google y DeepMind tienen la ventaja de su acceso a YouTube. En el lanzamiento de la primera versión del modelo Veo ya indicaron que el modelo "pudo" haber sido entrenado con contenido de YouTube "de acuerdo al acuerdo de Google con los creadores de YouTube". Lo mismo parece haber ocurrido con la segunda iteración, y desde luego el acceso a esa inmensa cantidad de contenidos puede contribuir mucho a que sus modelos sean más potentes.

Imagen | Google DeepMind

source

Segun xataka.com