#crypto #cryptomonedas #bitcoin

OpenAI, desarrollador de ChatGPT, aboga por el uso de la inteligencia artificial (IA) en la moderación de contenidos, destacando su potencial para mejorar la eficiencia operativa de las plataformas de redes sociales al agilizar el procesamiento de tareas complejas.

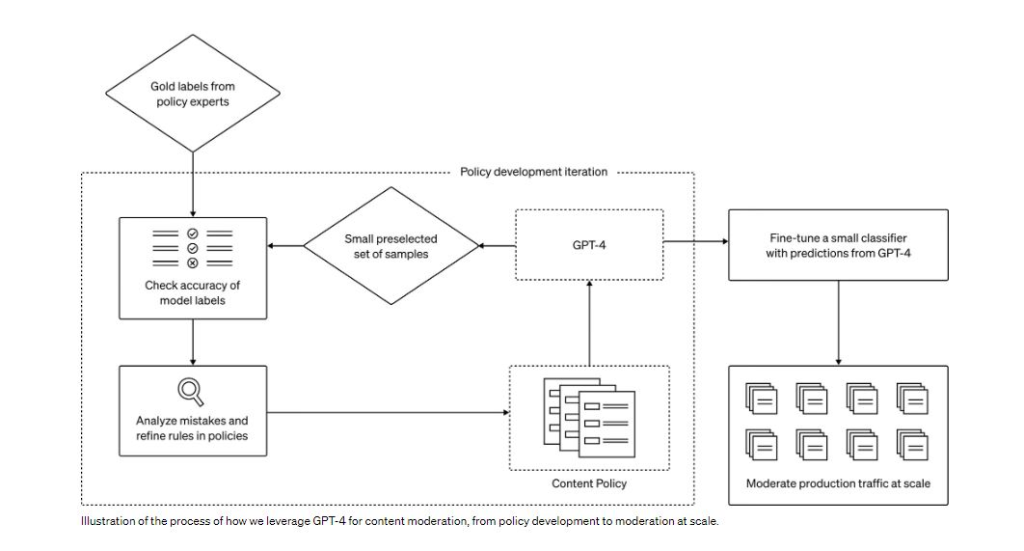

La empresa dijo que su último modelo de IA, GPT-4, podría acortar significativamente los plazos de moderación de contenidos de meses a horas, garantizando una mayor coherencia en el etiquetado.

La moderación de contenidos es un reto para las empresas de redes sociales como Meta, matriz de Facebook, ya que requiere la coordinación de numerosos moderadores en todo el mundo para evitar que los usuarios accedan a material nocivo, como pornografía infantil e imágenes muy violentas.

"El proceso (de moderación de contenidos) es intrínsecamente lento y puede provocar estrés mental en los moderadores humanos. Con este sistema, el proceso de desarrollo y personalización de las políticas de contenidos se reduce de meses a horas".

Según el comunicado, OpenAI está investigando activamente la utilización de grandes modelos lingüísticos (LLM, por sus siglas en inglés) para abordar estos problemas. Sus modelos lingüísticos, como GPT-4, los hacen idóneos para la moderación de contenidos, ya que pueden tomar decisiones de moderación guiadas por directrices normativas.

Las predicciones de ChatGPT-4 pueden refinar modelos más pequeños para manejar datos extensos. Este concepto mejora la moderación de contenidos de varias maneras, entre ellas la coherencia en las etiquetas, un circuito de retroalimentación rápido y el alivio de la carga mental.

En el comunicado se destaca que OpenAI está trabajando actualmente para mejorar la precisión de las predicciones de GPT-4. Una de las vías que se están explorando es la integración del chain-of-thought reasoning o razonamiento en cadena, también conocido como la autocrítica. Además, está experimentando con métodos para identificar riesgos desconocidos, inspirándose en la IA constitucional.

El objetivo de OpenAI es utilizar modelos para detectar contenidos potencialmente nocivos a partir de descripciones generales del impacto. La información obtenida a partir de estos esfuerzos contribuirá a perfeccionar las actuales políticas de contenidos o a elaborar otras nuevas en ámbitos de riesgo desconocidos.

El 15 de agosto, Sam Altman, CEO de OpenAI, aclaró que la empresa se abstiene de entrenar sus modelos de IA con datos generados por los usuarios.

Colecciona este artículo como NFT para preservar este momento de la historia y mostrar tu apoyo al periodismo independiente en el criptoespacio.

Aclaración: La información y/u opiniones emitidas en este artículo no representan necesariamente los puntos de vista o la línea editorial de Cointelegraph. La información aquí expuesta no debe ser tomada como consejo financiero o recomendación de inversión. Toda inversión y movimiento comercial implican riesgos y es responsabilidad de cada persona hacer su debida investigación antes de tomar una decisión de inversión.

Sigue leyendo:

Las inversiones en criptoactivos no están reguladas. Es posible que no sean apropiados para inversores minoristas y que se pierda el monto total invertido. Los servicios o productos ofrecidos no están dirigidos ni son accesibles a inversores en España.

source

Según es.cointelegraph.com