#crypto #cryptomonedas #bitcoin

Meta AI acaba de publicar un preprint en el que se muestra un nuevo y radical marco "Megabyte" para construir sistemas generativos de transformación preentrenados (GPT).

Calificada de "prometedora" por Andrej Karpathy, de OpenAI (antiguo director de IA en Tesla), la nueva arquitectura está diseñada para procesar grandes volúmenes de datos -como imágenes, novelas y archivos de vídeo- sin utilizar un proceso conocido como tokenización.

Promising. Everyone should hope that we can throw away tokenization in LLMs. Doing so naively creates (byte-level) sequences that are too long, so the devil is in the details.

Tokenization means that LLMs are not actually fully end-to-end. There is a whole separate stage with… https://t.co/t240ZPxPm7

— Andrej Karpathy (@karpathy) May 15, 2023

La tokenización es un proceso con pérdidas comparable a la compresión de archivos. Para procesar grandes cantidades de datos, los modelos GPT convierten los bytes en tokens. A continuación, el transformador procesa los tokens y los utiliza para generar tokens de salida, que luego se descodifican.

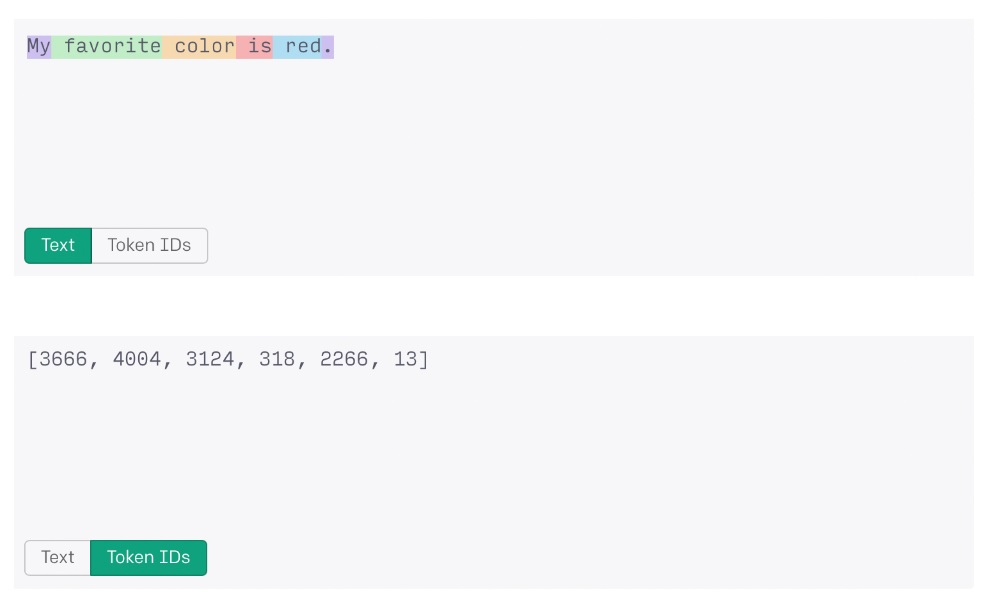

El proceso de tokenización permite a un sistema de IA procesar cadenas de datos más grandes como números. Las palabras "mi color favorito es el rojo", si las procesara ChatGPT de OpenAI, por ejemplo, se convertirían en la cadena de tokens "3666, 4004, 3124, 318, 2266, 13″ para su procesamiento.

Desgraciadamente, incluso mediante la tokenización, la cantidad de datos que pueden procesar los sistemas actuales de última generación sigue teniendo un límite duro. Para GPT-3.5, el límite es ligeramente superior a 4,000 tokens o unas 3,000 palabras, mientras que GPT-4 alcanza un máximo de 32,000 tokens o unas 24,000 palabras.

El nuevo sistema Megabyte de Meta abandona la tokenización en favor de una novedosa arquitectura de predicción multicapa capaz de modelar de extremo a extremo más de un millón de bytes de datos.

La mayoría de los sistemas de codificación estándar de la lengua inglesa utilizan la codificación estándar de 8 bits. En este paradigma, cada carácter ocupa un byte de datos. Por tanto, un sistema de inteligencia artificial capaz de procesar un millón de bytes de datos sin tokenización podría trabajar con documentos de texto que contuvieran 750,000 palabras, lo que supone un aumento del 3,025% respecto a GPT-4.

A modo de comparación, GPT-4 puede procesar actualmente unos 10 artículos periodísticos de gran extensión en una sola consulta, mientras que Megabyte sería capaz de analizar la totalidad de Guerra y Paz de León Tolstoi más otras dos novelas más o menos largas.

El modelo Megabyte de Meta también obtuvo buenos resultados en las pruebas de ImageNet y en las comparativas relacionadas con el procesamiento de archivos de audio, igualando o superando en ambas a los modelos de transformadores basados en bytes existentes, como PercieverAR de DeepMind:

"Megabyte iguala el rendimiento puntero de PerceiverAR utilizando sólo la mitad de computación".

Las implicaciones de esta investigación podrían ser de gran alcance. La tokenización se considera un obstáculo en este campo debido a sus límites de datos duros y a la cantidad de energía y tiempo necesarios para entrenar los sistemas.

Sin la tokenización, debería ser posible entrenar modelos de inteligencia artificial con un soporte básico más sólido para las lenguas no inglesas, especialmente las que no pueden codificarse fácilmente en caracteres estándar de 8 bits.

Esto podría conducir a una mayor democratización de estas tecnologías y permitir que todo, desde bots de comercio de criptomonedas hasta tecnologías DAO, se construya en códigos de lenguaje nativos en todo el mundo.

También aumentaría la capacidad de modelos como ChatGPT para trabajar con archivos de imagen, vídeo y audio para incluir la generación de clips multimedia aproximadamente en el mismo tiempo y con el mismo consumo de recursos que el texto.

Aclaración: La información y/u opiniones emitidas en este artículo no representan necesariamente los puntos de vista o la línea editorial de Cointelegraph. La información aquí expuesta no debe ser tomada como consejo financiero o recomendación de inversión. Toda inversión y movimiento comercial implican riesgos y es responsabilidad de cada persona hacer su debida investigación antes de tomar una decisión de inversión.

Las inversiones en criptoactivos no están reguladas. Es posible que no sean apropiados para inversores minoristas y que se pierda el monto total invertido. Los servicios o productos ofrecidos no están dirigidos ni son accesibles a inversores en España.

source

Según es.cointelegraph.com