* xataka.com * #android #tech #tecnologia

Stable Diffusion se ha convertido en uno de los motores de IA generativa más espectaculares a la hora de crear imágenes, pero si por sí solo ya había demostrado una capacidad asombrosa, hace unos días apareció una nueva tecnología que permite complementarlo y llevarlo a otro nivel. ¿Su nombre? ControlNet.

Qué es Control Net. Todo partió de un estudio reciente en el que se presentaba una nueva estructura de red neuronal llamada Controlnet. El objetivo era "controlar los grandes modelos de difusión preentrenados para que admitan condiciones de entrada adicionales". O lo que es lo mismo: modificar la salida de Stable Diffusion para que se ajuste a ciertas condiciones de control o modelos. Eso da más versatilidad que nunca a esta plataforma, como están descubriendo los usuarios que están probando (y alucinando con) esta nueva tendencia.

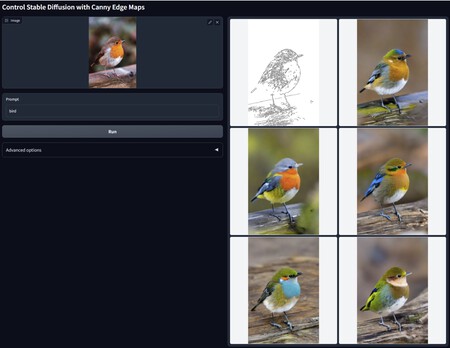

El modelo "Canny Edge" permite que a partir de la imagen de partida (esquina superior izquierda) y el prompt obtengamos variaciones mucho más afines a lo que buscamos.

Modelos para todos. Esta tecnología se utiliza aplicando los llamados "modelos preentrenados" a Stable Diffusion, algo que explican en el repositorio del proyecto. Hay ya varios modelos disponibles como Canny Edge —que detecta bordes—, Open POSE —que detecta poses generando un "esqueleto" de la imagen original— o User Scribble —que permite dibujar un garabato y que se genere una imagen basada en él—. Al aplicar Stable Diffusion sobre cualquier prompt con la imagen y el modelo establecidos, se obtienen variantes mucho más potentes para las creaciones.

Dale un garabato, que ya se encarga él de lo demás.

Garabatos nivel dios. Hay quien ya ha calificado de modelos como el "Scribble" como una bendición para quienes usaban este tipo de sistema para crear sus imágenes. Ya existían soluciones similares integradas en StableDiffusion 2.5 como img2img, pero esto lleva esta opción a un nivel alucinante.

Con el modelo "Human Pose" es posible extraer el "esqueleto" de la imagen de partida y, una vez establecido el prompt ("un astronauta en la Luna") dejar que Stable Diffusion cree variantes que se ajusten a esa posición y a ese prompt.

Y vídeos. Esta puede ser la base para crear pequeñas animaciones en las que se combinan el uso de ControlNet y estos modelos de forma muy efectiva. Todo esto puede ser instalado y usado en local gracias a proyectos como Automatic1111, sobre todo si tenemos un PC con una gráfica potente (se recomiendan 12 GB de memoria gráfica), pero es posible usar estos modelos igualmente con configuraciones más modestas.

Esto es un no parar. Si Stable Diffusion ya ofrecía buenos resultados, este tipo de "extensión" hace que esta plataforma se convierta en una opción aún más potente para asistir cualquier trabajo o proyecto creativo. El ritmo al que evolucionan estos proyectos es frenético, y aunque ciertamente los resultados pueden tener defectos, las herramientas son espectaculares.

Imagen: Yamkaz

source

Segun xataka.com